Wird mit Big Data alles anders und warum brauchen wir heute Big Data? Gastautor Georg Polzer, CEO und Mitgründer der Zürcher Firma Teralytics, beschreibt konkrete Anwendungsbeispiele von Big Data.

Big Data ist bei weitem nicht so revolutionär wie viele Marketing-Materialien dies versuchen darzustellen. Es ist vielmehr eine logische und wichtige Erweiterung des bestehenden Werkzeugkastens für die Datenanalyse. Relationale Datenbanken werden auch in 20 Jahren ihre Berechtigung haben. Jedoch liefern Big-Data-Technologien neue Einsichten und Entscheidungshilfen, die heute mit bestehenden Datenbank-Systemen unmöglich sind. Doch warum sich um Big Data kümmern, wenn im Unternehmen der Aufbau einer klassischen Business-Intelligence-Infrastruktur auf Basis eines Data Warehouse noch gar nicht abgeschlossen ist? Wäre das nicht der zweite Schritt vor dem ersten?

Big Data sollte Teil der Datenstrategie sein

Einerseits ist es richtig, dass dem erfolgreichen Abschluss einer Data-Warehouse-Initiative höchste Priorität eingeräumt werden muss. Doch wird mit Big Data als Teil der Datenstrategie zu lange gewartet, bestehen mehrere grosse Gefahren. Es wird keine Datenbasis aufgebaut, damit die Firma verlässliche Analysen durchführen kann. Wenn nicht früh genug mit dem Datensammeln begonnen wurde, so fehlt eine möglichst verlässliche Datenbasis, um Aussagen über mögliches Kundenverhalten in der Zukunft zu machen. Zudem versäumt die Firma, Fähigkeiten im Umgang mit Big Data sukzessive aufzubauen. Deshalb ist es für eine Firma sinnvoll, so früh wie möglich mit dem umfänglichen Speichern aller verfügbaren und potenziell wertvollen Unternehmensdaten zu beginnen. Durch massiv sinkende Preise für Speicherkapazität wird das Speichern grosser Datenmengen ermöglicht. Damit entfällt auch der Bedarf für eine vorherige, aufwändige Evaluation und Extraktion der Daten, wie das bei ETL-Prozessen für Data-Warehouse-Projekte der Fall ist.

Big Data senkt Kosten und steigert Profit

Big Data hilft Kosten zu sparen und Profit zu steigern. Falls ein Datenbanksystem an seine Grenzen kommt und nur teurer Hardwarezukauf eine Besserung bringen könnte, bieten kostengünstige Tools aus der Big-Data-Welt kosteneffiziente und skalierbare Speicherung und Analyse von komplexen Daten. Mit Einsichten aus Big Data lässt sich aus der Vergangenheit lernen, aber vor allem auch die Zukunft hochrechnen. Aus Verkaufsdaten kann mögliches Kundenverhalten gelesen werden, aus Produktionsdaten der Ausfall einer Maschine und anhand von Patienten-Daten die wahrscheinliche Entwicklung eines Krankheitsbildes. Dies erlaubt frühe, strategische Planung und ergibt einen Wettbewerbsvorteil gegenüber der Konkurrenz.

24 Terabyte Log-Daten pro Jahr eines Finanzdienstleisters

Die Abteilung für IT-Risk bei einem grossen europäischen Finanzdienstleister muss überwachen, wann welcher Benutzer auf welche sensitiven Daten in ihrem Data Warehouse zugegriffen hat. Diese Information ist jährlich in 24 Terabyte Log-Daten gespeichert, die die Datenbank-Zugriffe als SQL-Abfrage enthalten. Um die Frage nach kritischen Zugriffen zu beantworten, wurde ein Lösung auf Basis von Hadoop implementiert, die eine skalierbare und zeitnahe Auswertung der Log-Daten erlaubt. Ausserdem ist das System in der Lage, Zugriffsmuster von Usern zu lernen, um tatsächliches mit typischem Zugriffsverhalten in Beziehung zu setzen und bei verdächtigem, untypischem Zugriffsverhaltens eine Warnung auszugeben.

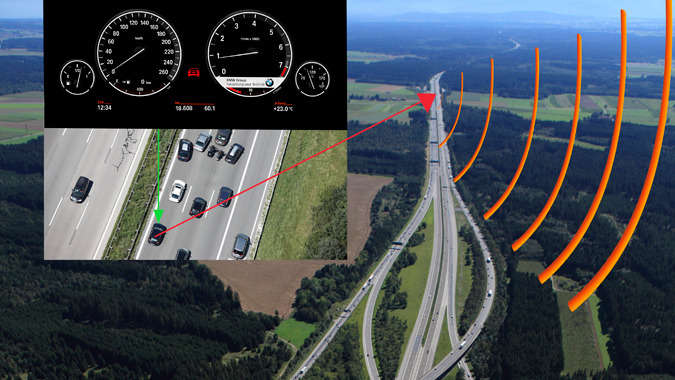

Ein zweites Praxis-Beispiel liegt bei einem grossen europäischen Autohersteller vor. Die Fahrzeuge senden über das Navigationssystem ständig ihre Position und aktuelle Geschwindigkeit an einen zentralen Server. Diese grossen Mengen an Verkehrsdaten werden nun genutzt, um Verkehrsverhältnisse vorherzusagen. Wenn mehrere Fahrzeuge des Herstellers auf der selben Autobahn mit 40 km/h unterwegs sind, ist dies Hinweis für einen Stau. Unter Einbezug von Wetterverhältnissen, aber auch Daten und Uhrzeiten kann nun die Routenplanung des Navigationssystems verbessert werden, da bereits Stunden im Vorhinein das Entstehen eines Staus vorausgesagt werden kann.

Start-Projekte mit Big Data im Kleinen

Diese Beispiele zeigen in welcher Breite die Nutzung von grossen Datenmengen Gewinne für Unternehmen bringen können. Dank der Skalierbarkeit von Big-Data-Technologien wie Apache Hadoop ist es möglich, mit einem kleinen, kostengünstigen Projekt den Nutzen zu erproben und nach erfolgreichem Abschluss den Umfang der Projekte und Investitionen sukzessive zu erhöhen.

(Georg Polzer)

Event zu Big Data Erfolgsgeschichten am 14. Juni

Teralytics ist ein ETH-Spinoff, das Polzer zusammen mit dem ETH-Informatik-Professor Donald Kossmann aufbaute. Am 14. Juni bietet der Event «Big Data Erfolgsgeschichten» Referenten und Projekte aus der Praxis im Hotel Radisson Blu am Zürcher Flughafen. Greenbyte.ch ist Medienparter.

Weitere Themen:

Neueste Artikel von Gast-Autor (alle ansehen)

- Günstigerer Mobilfunk scheitert an Strahlung und Lobbyismus - 9. Dezember 2016

- Bundesrat will Zensur ohne Gerichtsbeschluss - 29. März 2016

- Proprietär vs. Open Source – Die ewige Debatte um die Sicherheit - 23. Oktober 2015

Big Data sagt Zukunft voraus http://t.co/uFtiguA3