Datenberge, Ressourcen-Management und Effizienz im Rechenzentrum führt zu mehr als nur optimierten Prozessen. Sie ermöglichen für Schweizer Unternehmen Big-Data-Werkzeuge wie Hadoop, die zuvor nur Unternehmen wie Google nutzten. Dies zeigt das Praxisbeispiel von PWC bei einer Investmentbank.

Mit Big Data können Schritt für Schritt zu Antworten kommen, wenn sie die Fragen zu Beginn noch nicht einmal kennen. (pd)

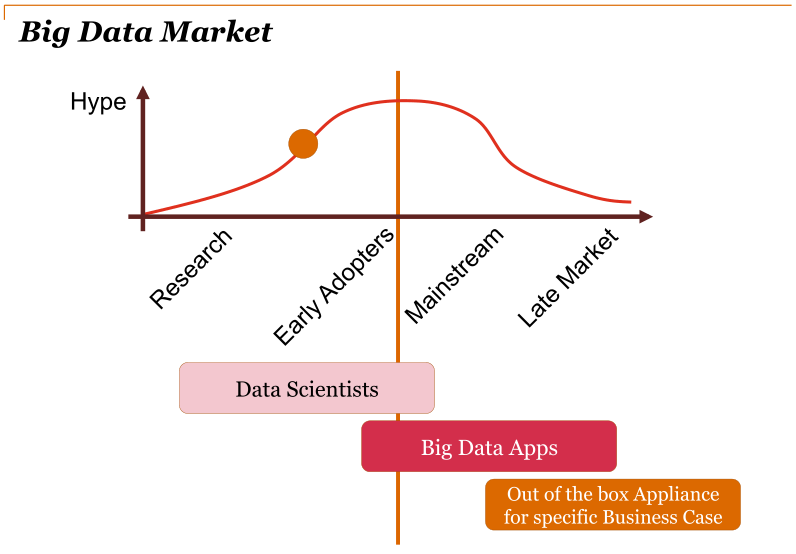

Der Markt für Big Data ist noch in einer frühen Phase im Vergleich zwischen Angebot und Begeisterung. (PWC)

Effizienz im Rechenzentrum führt zu mehr als nur optimierten Prozessen. Sind die Server virtualisiert, also die Software von der Hardware getrennt, lassen sich interne Ressourcen verschieben und bei Bedarf externe Ressourcen anknüpfen. Die Disney Technology Shared Services Group als Beispiel hat mit virtualisierten Rechenzentren das jährlichen Kostenwachstum von 23 Prozent auf minus 3 Prozent gedreht; die Prozessleistung stieg von 17 auf 45 Prozent (PWC Technology Forecast, 3/2010). Die Flexibilität der virtualisierten Infrastruktur ermöglicht das dynamische Anknüpfen von weiteren, neuen Prozessen. Beispielsweise das Analysieren von riesigen Datensätzen in externen Clouds wie Disneys Web-Besucher-Statistiken. Mit Clouds sind hier die virtualisieren Server in anderen Rechenzentren gemeint. Sie verarbeiten in diesem Beispiel die Daten von Disney und senden die Resultate zurück. Dahinter steckt jedoch die Verarbeitung riesiger Daten.

Die Werkzeuge der Datensammler und Social-Media-Riesen wie Google, Twitter und Facebook sind heute für alle Unternehmen aller Grössen zugänglich. «Es ist billiger, Daten zu speichern, als wegzuschmeissen», sagte Georg Polzer von Teralytics zur Eröffnung des Events «Big Data Erfolgsgeschichten». Der Anlass fand statt im Juni im Hotel Radisson Blue des Flughafens Zürich. Präsentationen mit Praxisbeispielen hielten auch Vertreter von SAP, Oracle, Cisco, Netapp und Splunk. Organisiert und durchgeführt wurde der Anlass von Extendance und Teralytics. Greenbyte.ch ist Medienpartner dieses Anlasses.

Hadoop-Nutzerszenarien von ETH bis Facebook

Die Werkzeugen wie Hadoop, Map Reduce und anderen Open-Source-Technologien produzieren schnelle Resultate, weil sie die grosse Daten-Analyse-Arbeitsaufträge auf viele Computer-Systeme verteilen und parallel verarbeiten. Apache Hadoop basiert auf Java und dem Googles Datei-System. Es wird offen und frei von der Apache Software Foundation entwickelt. Die Hadoop-Kundeninfo bietet einige Anwendungsszenarien von grossen und kleinen Nutzern. Von der ETH Zürich bis zu Yahoo. Facebook nutzt Hadoop, um Kopien von internen Log und Dimension-Data-Quellen zu speichern sowie als Quelle von für Berichte, Analysen und machinelles Lernen. Facebook betreibt zwei grosse Hadoop-Cluster aus 1100 Server mit 8800 Kernen und 12 Petabyte Speicher, sowie aus 300 Server mit 2400 Kernen und 3 Petabyte Speicher. Ein weiteres Beispiel für Hadoop-Grossnutzer ist Linkedin, die mit Hadoop-Clustern aus 2000 Servern für aktuell 175 Millionen Mitglieder die «Personen, die Sie vielleicht auch kennen» aussortieren. Yahoo nutzt Hadoop mit über 100’000 Kernen in 40’000 Servern, beispielsweise um die Forschung in Werbesystemen und sie Suche zu unterstützen.

Linkedin benötigt 2000 Hadoop-Server, um die Funktion «Personen, die Sie vielleicht auch kennen» für 175 Millionen Mitglieder anzubieten.

Datenanalyse einer Investmentbank im Konkurs

Ein Beispiel aus der Praxis zeigte Alexej Freund, Manager Consulting von Pricewaterhouse Coopers (PWC) in Zürich. Das Problem waren rund 4 Terabyte unbrauchbare, aber benötigte Daten einer konkursiten Investmentbank. «Die Bank sollte abgewickelt werden. Man musste also feststellen, wo die Bank mit ihren komplexen Verträgen und Produkten involviert war. Dazu benötigt man eine separate Abfrage über die Datenbanken hinweg, die mit normalen Mitteln nicht möglich ist», sagte Freund. Um das Problem zu lösen, stellte Freund einige praktische Lösungsoptionen als Vergleich auf.

- Lösungsoption Null stellt den Nutzer ins Zentrum, mit dem was vorhanden ist: Die Daten werden in Microsoft Excel geladen und per Befehl «Ctrl+F» durchsucht und angezeigt. Die Vorteil der Intuitivität wird hinweg gefegt von der limitierten Skalierung (maximal 1 Million Reihen) und der lahmen Suchgeschwindigkeit, die im Kundenbeispiel mehrere Tage bis Wochen pro Aufruf dauern kann.

- Die Option 1 ist eine Suche mit hierarchischen SQL-Cursor und -Loops. Der erste Cursor läuft durch die Datenbank und findet Tabellen, ein zweiter Cursor/Loop läuft durch die Tabelle und findet die Werte in Spalten und Reihen. Der Vorteil: alle Tabellen und Reihen könnten durchsucht werden. Nachteil: Ein SQL-Abfrage müsste programmiert werden; schlechte Leistung (mehrere Tage); Suche in Tabellen und alle Daten müssten in Datenbanken gespeichert sein; Indexing und Daten konsumieren Speicherplatz.

- Als Option 2 bringt Freund einen Datenbank-Volltextsuche in den Vergleich ein. Mittelns einer Volltext-Abfrage werden Wörter und Sätze in Datenbank-Tabellen durchsucht. Als Vorteil lässt sich die Abfrage leichter implementieren. Als Nachteil können im Gegensatz zu Variante 1 nur Text abgesucht werden. Weitere Nachteile sind die zwar leicht bessere, aber immer noch schlechte Leistung wegen der gleichen Nachteile beim Speicherverbrauch wie in Variante 1.

- In Option 3 kommt eine Dokumenten Management Plattform zum Einsatz. Sie funktioniert mit Volltextsuche von indexierte Inhalten. Als Vorteil muss nur die eigentliche Information in Datenbanken gespeichert sein. Der Nachteil ist das Fehlen von linear skalierbarer Leistung, die Abfragen sind komplex und der Index muss aktualisiert sein.

- Mit Option 4 kommt eine herstellerspezifische Lösung in die Auswahl wie Oracle Exalytics (oder SAP Hana). Sie ist optimiert, Daten in den schnellen Arbeitsspeicher zu laden (sogenannte «In-Memory-Analyse») und sie ist deshalb sehr leistungsfähig. Um die Daten zu finden, kombiniert diese Variante die Volltextsuche mit In-Memory-Analyse. Der Vorteil ist die beste Leistung und die schnellste Reaktionszeit. Die Nachteile sind der sehr hohe Preis im sechs bis siebenstelligen Bereich, ein hoher Bedarf an Arbeitsspeicher in den Computern, Big Data muss unterteilt werden und wie in den Varianten 1 und 2 müssen alle Daten dazu in Datenbanken gespeichert sein.

- Als Option 6 kommen Cloud-basierte Lösungen in die Auswahl, also das Nutzen von externen, nach Verbrauch verrechneten Speicher- und Analyse-Dienstleistungen über das Internet mit verschiedenen Anbietern. Der Vorteil ist die einfache Einführung ohne Fachpersonal. «Doch Big Data heisst in der Cloud leider auch Big Bucks», so Freund. Je mehr Daten es zu analysieren gibt, umso höher sind die Kosten. Das hohe Daten-Aufkommen könnte zudem Schwierigkeiten verursachen und die Auswahl von Anbietern ist klein.

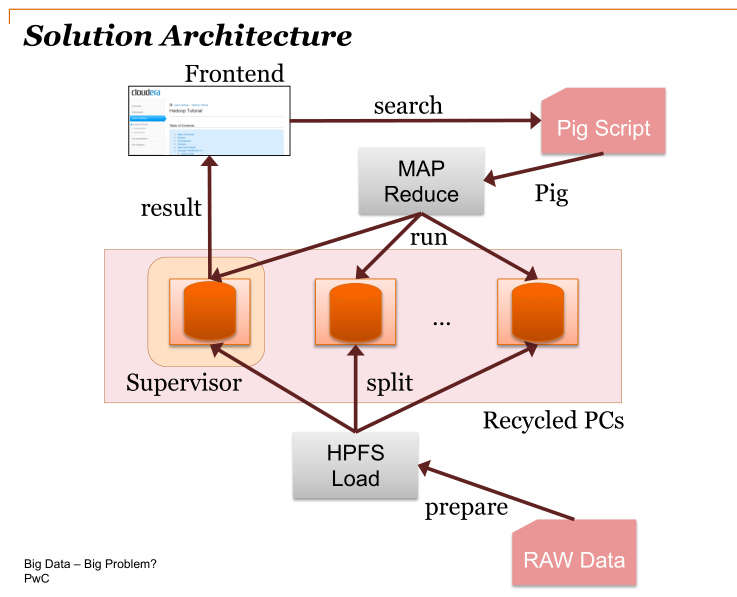

- Die finale Option Nummer 7 war eine Unkonventionelle. Die Lösung wurde selbstgemacht mit frei erhältlicher Opensource-Software wie Apache Pig und Hadoop. Sie basiert auf einem Computer-Rechennetzwerk (Cluster), das unstrukturierte Daten parallel auf die Rechner verteilt und somit schnell analysiert. Die Hadoop-Plattform löst Probleme aus einer Mixtur von komplexen und unstrukturierten Daten, speziell wenn die Daten nicht schön in Tabellen passen. Zu den Vorteilen zählt laut Freund die Einfachheit von vorgefertigten Paketen (die in diesem Falle von Umsetzungspartner Teralytics stammen), die hohe Leistung eines Clusters, die schnellen Reaktionszeiten und der tiefe Preis.

Proof of Concept mit Recycling-PC

Die Option 7 hat Freund bei PWC als «Proof of Concept» umgesetzt, «weil es mit dem geringsten Aufwand realisierbar war». Ihn interessierte laut eigener Aussage das Resultat mit dem alleinigen Gebrauch von Standard-Opensource-Software. Die Macht von Opensource-Werkzeugen wie Apache Pig und Hadoop zeigt sich in diesem Beispiel. «Wir haben uns dessen bedient, was wir herumstehen hatten», sagte Freund. Als Hardware kamen aussortierte PC mit Pentium-4-Systemen zum Einsatz. Die Mitarbeiter der PWC-IT-Abteilung bereiteten in ihrer freien Zeit alles nötige vor: Sie installierten Ubuntu-Linux und die Apache-Software auf den PC, vernetzten sie zum über einen Netzwerk-Switch und fertig war das Hadoop-Cluster-Mini-Rechenzentrum aus Recycling-PC. «Zum Schluss musste noch ein Web-Interface zur Daten-Abfrage nach dem Vorbild von Google programmiert werden, dazu wurde die Programmiersprache Python genutzt.», so Freund. Das Programmieren sei der aufwändigste Teil des Projekts. Auch für die Konfiguration von Apache Pig ist Programmierer-Fachwissen nötig.

Der gesamte Aufbau ging sehr schnell, wie der Projektplan zeigt. In 5 bis 10 Tagen war alles fertig. Das Team von PWC und Teralytics hatte den Auftrag erledigt ohne Kosten für Software und Hardware. «Nicht das typische PWC-Projekt», wie Freund verschmitzt anmerkte. «Aber es ging schnell und wir konnten das Problem des Kunden lösen.» Er betont, dass dieses konkrete Beispiel keine Lösung für Unternehmen ist. Als Schattenseite hat sich die nötige Datenduplizierung und die aussschliessliche Arbeit mit Kopien von Daten herausgestellt.

Die Lösung wir heute operationell beim Kunden eingesetzt, wozu PWC nun mit Oracle und Teralytics eine Partnerschaft einging. Recycling-PC sind deshalb nicht mehr im Einsatz: Sie würden die Ausfallzeiten stark erhöhen und somit schnell sehr hohe Kosten und Imageschaden verursachen. Nichts geändert hat sich an der Einfachheit des Supports und die Erweiterbarkeit des Systems. Heute werden für neue Systeme deshalb Server von Oracle Sun genutzt. Freund sieht eine spannende Zeit kommen: «Wir führen in diesem Kontext weitere Gespräche. Es macht mir, da ich aus dem Bereich Data-Warehouse komme, sehr viel Spass, mit diesen neuen Werkzeugen zu arbeiten. Sie machen mir die Arbeit einfacher.»

(Marco Rohner)

Weitere Themen:

Neueste Artikel von Marco Rohner (alle ansehen)

- Bund beschafft freihändig 49 Mio. Franken Auftrag von Oracle - 24. November 2016

- Ubuntu und Kubuntu 16.04 LTS im Test - 21. Oktober 2016

- Labdoo.org gewinnt Lenovo Schweiz - 4. Juli 2016

Big Data: Hadoop sortiert Datenberg einer Investmentbank http://t.co/dKBfKJaI #hadoop

Greenbyte.ch http://t.co/dKBfKJaI #hadoop